2. 华中科技大学 多谱信息处理技术国家级重点实验室, 武汉 430074

2. National Key Laboratory of Science and Technology on Multi-Spectral Information Processing, Huazhong University of Science and Technology, Wuhan 430074, China

随着机器计算能力的提升、人工智能与航空电子技术的日渐成熟,小型无人机逐渐步入应用,在摄影摄像、智能监控、地质勘探、农业自动化、灾害防范与救助等领域广泛使用,具有很高的商业与社会价值[1-2]。另一方面,由于无人机具有体积小、监测难度大的特点,其普及应用带来了较大的安全隐患,近年来无人机在机场附近违法飞行导致扰航的事件时有发生。此外,无人机也常被不法份子用于搬运违规物品、非法拍摄等。在机场、边防、监狱、军事要地、以及其他涉及安全与机密的场所,使用技术手段对非法进入的无人机进行跟踪、监测、打击或者捕获的需求与日俱增[3]。

与基于雷达、射频、音频等技术的反无人机方案[4]相比,基于视频技术的方案具有可视化程度高、定位准确的特点,可实现检测、跟踪、识别、取证等功能的有机结合,并且为激光毁伤、干扰、捕获等后续手段提供准确的位置信息。视觉跟踪技术[5]作为其中的重要模块,其算法准确度与鲁棒性很大程度上影响了反无人机方案的成功率,因此提高针对无人机目标的视觉跟踪技术,具有重要的实用价值[6]。

与此同时,近年来安全与军事领域趋向于智能化,视觉目标跟踪技术在其中的应用受到各个国家的重视。使用跟踪算法辅助导弹的精确制导,实现对空中战争目标的精准打击,是一项非常重要的应用需求[7-8]。通过视觉跟踪技术与雷达等其他探测设备的配合实现更精确的侦查预警,可以有效提高军队的战斗能力。

目前主流跟踪算法[9-12]研究的目标大多数形状规则方正、在跟踪过程中与成像器角度比较固定,不存在明显形变。相比之下,空中飞行器由于成像姿态、角度与距离变化导致目标形状、大小、宽高比持续变化,同时存在复杂背景干扰的问题,跟踪难度更大,两者的典型例子对比如图 1所示。现有跟踪方法由于目标表征模型不够精确,容易受上述变化影响,随着误差累积定位到目标局部或者扩大区域,逐渐偏离目标,在长期跟踪任务中无法保证足够的精度与鲁棒性。

|

| 图 1 主流算法跟踪目标与空中飞行器目标对比 Fig. 1 Comparison of target tracked by mainstream algorithms and airborne targets |

空中飞行器类的目标由于与背景完全独立,表观特性通常与背景区域具有一定的反差,这一特点可通过视觉显著性机制来建模表达。针对此类形状变化较为突出的独立物体,我们研究如何在视觉跟踪场景中构建合理的目标显著性模型,用于提高跟踪器在目标尺度、形状变化、复杂背景等因素影响下的算法鲁棒性。

视觉显著性检测通过模拟人眼的视觉注意机制,在图像中选取优先处理区域,提供给其他较上层的算法使用,经典代表性方法包括基于空间域的方法、基于频谱域的方法、基于图论的方法等[13]。近年来提出的基于距离测度的方法[14-15]使用背景先验和距离度量来估计像素点的显著性,在数据集上取得了不错的效果。此外,针对视频序列中的显著性检测,一些研究者提出对于时间域的信息进行有效利用,建立时空(Spatio-temporal)注意力计算模型[16]。

在目标跟踪算法中引入显著性模型,可以模拟人眼视觉注意机制的作用,为采样、特征选择、目标定位等提供先验知识,从而提高跟踪效率和准确率。一些研究者提出适用于跟踪场景的显著区域判断方法,选择局部显著区域子块分别进行跟踪,再使用这些子块的跟踪结果来进行目标的定位[17-18]。另外一个常见的研究思路是对目标搜索区域进行显著图的计算,利用显著图完成目标的定位[19]。Choi等则采取多核多特征的策略,构造了一组基于显著性特征的相关滤波器,再对所有滤波器预测结果进行融合得到最终跟踪结果[20]。

有别于上述目标跟踪文献普遍使用单帧图像进行显著性估计的做法,由于跟踪场景中图像观测随时间递增,而且帧间存在运动关联,本文提出一种新颖的时空显著性计算模型,对时间域上的关联信息以及当前帧空间域图像观测信息进行集成利用。此外,模型的构建利用了目标跟踪任务场景提供的背景先验知识。因此,在本文模型中,目标邻域的显著性估计与目标跟踪形成迭代交互的2个联合子问题。

其中,目标跟踪算法给出了上一帧的目标定位信息,为图像显著性估算提供背景区域粗略位置、表观特性等方面的先验知识,用于指导显著性检测模型的构建。显著性模型通过构建像素级贝叶斯概率推断框架,集成时间域上的关联信息以及当前帧空间域图像观测信息。通过对跟踪场景先验知识以及多帧图像观测信息的融合利用,该方法能够在背景复杂的情况下,对目标邻域得到鲁棒的显著性估计结果。

反过来,计算得到的显著图用于模拟人眼系统注意机制,为目标跟踪算法提供特征采样方面的先验知识。具体的,以基于矩形模板目标表征的算法为基础,在显著图的指导下选取有效视觉特征,构建更为精确的目标表征模型。在空中飞行目标跟踪过程中,所构建的目标表征使得算法能够有效区分目标与背景区域,及时调整目标的宽高比与尺度估计,更为精确地定位不同背景干扰下的飞行目标,在长期跟踪过程中保持稳定准确的目标位置与尺度估计。

1 目标邻域的时空显著性估计 1.1 时空显著性建模对于目标附近每一个像素点是否属于显著区域,使用一个随机变量来表征其状态分布,并使用状态空间模型来进行描述。每一帧进行显著性估计的时候,通过目标对象的观测(观测概率)来对其状态(后验概率分布)进行估计,使用贝叶斯滤波方法进行概率推断。以x=[xp, yp]T记像素位置,t记帧数,yxt记像素位置x在第t帧的图像观测,cxt记像素位置x在第t帧的类别,c=1表示像素为显著区域,c=0表示像素为非显著区域。使用Yxk =[yx1, yx2, …, yx k]表示1~k时刻所有的观测值。应用贝叶斯滤波算法框架,并行地对一组像素点的显著性概率p(cxt =C| Y t)进行估计。

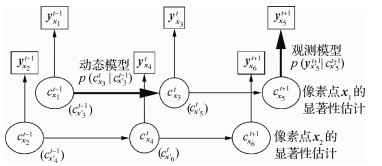

令p(cx0 | y x0)=p(cx0)为初始概率密度分布,假设t时刻的像素位置x对应于t-1时刻的像素位置x ′,并假定系统状态转移过程是一阶马尔可夫过程,即当前时刻的状态cxt只能通过前一时刻的状态cx ′t-1得到。另外,各个观测量之间假定为相互独立,系统的贝叶斯网络图如图 2所示,则可以使用两步的递推过程,随时间t的递增迭代地进行状态预测和状态更新步骤,获取状态的后验概率密度分布p(cxt | Yxt),进而获得状态的最优估计。

|

| 图 2 时空联合显著性估计问题的贝叶斯网络表示 Fig. 2 Bayesian network representation of spatio-temporal saliency estimation problem |

1) 状态预测过程。使用状态转移模型对上一时刻的后验概率分布p(cx ′t-1| Y t-1)进行概率传递,其核心是通过状态转移概率p(cxt|cx ′t-1)的建模与计算,对视频序列时间域提供的信息进行有效利用,状态预测公式为

| $ \begin{array}{l} p\left( {c_\mathit{\boldsymbol{x}}^t = C|{\mathit{\boldsymbol{y}}^{t - 1}}} \right) = \\ \;\;\;\;\;\;\;\;\int {p\left( {c_\mathit{\boldsymbol{x}}^t = C|c_{{\mathit{\boldsymbol{x}}^\prime }}^{t - 1}} \right)p\left( {c_{{\mathit{\boldsymbol{x}}^\prime }}^{t - 1}|{\mathit{\boldsymbol{y}}^{t - 1}}} \right){\rm{d}}c_{{\mathit{\boldsymbol{x}}^\prime }}^{t - 1}} \end{array} $ | (1) |

式中:x ′表示t时刻的像素点位置x在t-1时刻对应的位置。记像素位置x在第t帧的后向光流场为Mt(x),则像素位置x的在第t-1帧在对应的位置为

| $ {\mathit{\boldsymbol{x}}^\prime } = \mathit{\boldsymbol{x}} + {M^t}(\mathit{\boldsymbol{x}}) $ | (2) |

状态传递概率p(cxt |cx ′t-1)代表了对前一帧估计结果的置信程度,理论上应当大于0.5,经验性地设置p(cxt |cx ′t-1)=1即最高的置信程度。由于x ′可以是亚像素级别的位置,而且对于上一帧搜索区域中的像素x∈Ωt-1有已估计的显著性概率图p(cxt-1 | Y t-1),因此式(1)中像素位置x′的上一帧显著性概率p(cx′t-1| Yt-1)可直接通过插值计算获得。

2) 状态更新过程。根据观测模型提供的似然概率函数对状态预测结果进行更新修正,其核心是观测模型p(y xt |cxt)的建模,根据贝叶斯法则可得到更新公式:

| $ p\left( {c_\mathit{\boldsymbol{x}}^t = C|{\mathit{\boldsymbol{Y}}^t}} \right) \propto p\left( {\mathit{\boldsymbol{y}}_\mathit{\boldsymbol{x}}^t|c_\mathit{\boldsymbol{x}}^t = C} \right)p\left( {c_\mathit{\boldsymbol{x}}^t = C|{\mathit{\boldsymbol{Y}}^{t - 1}}} \right) $ | (3) |

本模型应用背景先验理论,使用目标跟踪模块提供的背景区域作为先验知识,假设在像素位置与颜色空间距离背景越远的区域,其显著性程度越高,因此观测模型p(yxt|cxt=C)中的观测量yxt由不同的距离测度来计算得到。使用颜色空间的马氏距离(Mahalanobis Distance),以及基于位置-灰度联合空间的最小障碍距离(Minimum Barrier Distance,MBD)作为联合观测量,进行目标搜索区域内像素点显著性似然概率的估计,即有yxt =[DMt(x), DMBDt(x)]。

背景先验理论[21]用于背景区域已知的情况下在自然图像中进行显著物体检测,在目标较大且处于图像中央的情况下,假设图像的边界为背景区域。本文提出在目标跟踪场景中对背景先验进行应用,背景区域的先验知识由目标跟踪模块提供,如图 3所示。

|

| 图 3 目标位置与提供的背景先验示意图 Fig. 3 Demonstration of target position and background prior provided |

具体地,已知第t-1帧的目标中心位置x=[xp, yp]T以及尺度大小[d1, d2]T,如图 3(a)红色矩形框所示,则在第t帧计算显著图的时候,取中心位置为[xp, yp]T、尺度大小为

目标跟踪算法中,为区分目标和背景像素,常见的做法是使用统计建模方法,对目标与背景建立基于颜色特征的表观模型。生成式模型致力于对目标/背景颜色空间的分布分别建立模型进行数据拟合,判别式模型则通过训练分类器,比如使用直方图分类器来对两者进行区分[22-23]。一方面,由于目标和背景像素在颜色空间具有多模分布的特点,而且模式个数不确定,生成式模型通常难以进行十分有效的数据拟合,另一方面,两者在颜色空间通常呈现线性不可分的特点,也给判别式模型分类器的训练带来了难度。

相对于目标而言,背景在颜色空间的分布通常具有更多的较为确定的规律性,且其模式分布与方位明显呈现较大的相关性。从图 3中的典型目标跟踪场景可以看到,目标上下左右4个方位的背景区域分别具有各自的简单模式分布。相比于对整个背景区域进行统计建模,按照不同方位分别进行统计建模的方法更为合理准确。因此,本文提出对背景先验的一种应用方式,通过统计各方位背景区域在颜色空间的分布,计算搜索区域每个像素点与各个方位背景区域在颜色空间上的距离,以此进行距离观测量的计算。

具体地,对于中心位置为[xp, yp]T,尺度大小为

| $ b_k^{ij} = \sqrt {\left( {{\mathit{\boldsymbol{C}}^{ij}} - {\mathit{\boldsymbol{m}}_k}} \right)\mathit{\boldsymbol{Q}}_k^{ - 1}{{\left( {{\mathit{\boldsymbol{C}}^{ij}} - {\mathit{\boldsymbol{m}}_k}} \right)}^{\rm{T}}}} $ | (4) |

式中:Cij为bkij所对应的像素位置上的颜色特征。对Ωt与每个背景子区域得到的距离图Bk=[bkij]进行归一化使得范围为[0, 1]。得到4个方位背景子区域的距离图之后,最终距离图B=[bij]为

| $ {b^{ij}} = \sum\limits_{k = 1}^4 {b_k^{ij}} - {\min _k}b_k^{ij} $ | (5) |

为防止背景中某个区域存在与目标颜色外观相近的疑似物体,式(5)在对与4个背景子区域的距离图求和之后,对于距离最小的距离图进行减除,使得估计结果对背景干扰更为鲁棒。在t时刻计算得到的距离图B即作为观测量DMt(x)进行使用。

1.3 基于最小障碍距离的观测量1.2节假设和背景区域在颜色上差异越大的像素,属于显著区域的概率也越高。类似地,在像素位置空间,和背景区域距离越远的像素,其显著性程度越高。由于我们以上一帧目标位置为中心选取背景区域,如果直接在像素位置空间上计算背景距离,则距离最大的点为上一帧目标中心,这导致在目标快速运动的情况下会出现较大的估计误差。因此,为了对位置空间的距离信息进行利用,综合地考虑位置和灰度两方面的信息,在位置-灰度联合空间上定义距离测度,以确保在目标和背景颜色特征相似、以及目标运动速度较快的情况下均能够给出鲁棒的显著性估计结果。

理论上,需要定义搜索区域Ωt中每个像素点到背景区域的距离测度。假定基于该区域的二维单通道图像来进行计算,应用背景先验将区域边缘像素取作背景种子点,区域中一条从某像素点到背景种子点的路径记为π=〈π(0), π(1), …, π(k)〉,其中π(i)和π(i+1)是图像区域Ωt中相互邻接的2个像素,使用4邻域的像素邻接定义。

定义Ƒ(π)为路径π的路径消耗函数,以S记背景种子像素的集合,则要计算的距离图D定义为

| $ D(\mathit{\boldsymbol{x}}) = {\min _{\pi \in {\mathit{\Pi }_{S,\mathit{\boldsymbol{x}}}}}}{\cal F}(\pi ) $ | (6) |

式中:ΠS, x为连接S和x之间的所有路径,式(6)对所有可能的路径进行寻优,找到路径消耗最短的路径,以其路径消耗衡量该像素点离背景区域S的距离。两个像素位置x1和x2之间的路径消耗函数可采用不同的方式进行定义,应满足性质Ƒ (x1→x2)= Ƒ(x2→ x1)≥0。距离测度的定义取决路径消耗函数Ƒ(π)的定义,最终取决于不同的应用。

一种经典的定义是使用测地距离[21](Geodesic Distance),可以对像素位置和灰度2个空间的距离进行综合的衡量。这种方法累加了路径上所有相邻像素点的灰度差作为路径消耗,其定义为

| $ {{\cal F}_G}(\pi ) = \sum\limits_{i = 1}^k {\left| {I(\pi (i - 1)) - I(\pi (i))} \right|} $ | (7) |

式中:I(·)为相应像素位置中的图像灰度值。文献[15]使用最小障碍距离作为一种新的距离测度来配合背景先验进行显著性检测,其路径消耗定义为

| $ {{\cal F}_{{\rm{MBD}}}}(\pi ) = \max _{i = 0}^kI(\pi (i)) - \min _{i = 0}^kI(\pi (i)) $ | (8) |

文献[15]中的实验表明,最小障碍距离检测相比于经典的测地距离,可以得出对噪声和分辨率更加鲁棒的显著性检测结果。该文献提出的快速最小障碍距离算法利用光栅扫描的方法进行路径消耗的快速近似计算,使得算法的实时性得到保证。将计算得到的最小障碍距离图归一化使得最大值为1,在第t帧得到基于最小障碍距离的观测量DMBDt(x)。

得到2个基于距离的观测量之后有yxt=[DMt(x), DMBDt(x)],可用于对像素点的观测概率p(yxt|cxt=C)进行计算。由于2个观测量均基于与背景的距离测度进行计算,均与显著性呈现正相关,具有较好的可分性,使用简单的最小二乘分类器对其进行统计分类,得到像素级的似然概率估计,应用于式(1)~式(3)表述的多帧联合显著性估计框架中可得到搜索区域像素的显著图。图 4(a)为目标搜索区域,图 4(b)为本文基于背景距离模型的像素级目标似然概率估计结果,相比于常见的基于颜色直方图模型[22-23]的估计(如图 4(c)所示),对背景噪声明显具有更好的鲁棒性,能够为跟踪算法的目标定位提供十分有用的信息。

|

| 图 4 基于颜色与基于距离的目标似然概率估计结果对比 Fig. 4 Comparison between results of color-based and saliency-based target likelihood estimation |

采用基于检测器的目标跟踪框架,其核心思想是在历史跟踪图像上采集正负目标样本训练分类器,在当前帧通过一定的预测搜索策略产生大量的候选样本,使用之前训练的分类器对这些样本是目标物体的概率进行估计,选取最佳样本作为跟踪输出结果。

具体选择结构化输出支持向量机[24]作为分类器。在训练阶段,采用最大间隔分类思想,寻找使得正负样本特征向量之间间隔最大的分类平面,得到分类器参数。在检测阶段,样本的分类标签通过特征向量与分类器参数线性运算得到。

具体的,在第t帧的时候,在图像It中采集大量候选样本形成集合Qt,从中选择一个作为的目标矩形框pt,以使得目标函数最大化:

| $ {p^t} = {\rm{argma}}{{\rm{x}}_{_{p \in {Q^t}}}}\left\langle {{\mathit{\boldsymbol{h}}_{{I^t},p}},{\mathit{\boldsymbol{\theta }}^{t - 1}}} \right\rangle $ | (9) |

式中:〈·〉表示向量内积操作;θt-1为第t-1帧使用历史数据训练得到的分类器模型参数,表示支持向量机分类平面的法向量;hI, p为对图像I中的矩形窗口p提取的特征描述符构成的目标表征向量。n个描述符根据在矩形窗口中的位置排列,按顺序堆叠成列向量对目标物体进行结构化表征,记为

| $ {\mathit{\boldsymbol{h}}_{I,p}} = {\left[ {\mathit{\boldsymbol{h}}_{I,p}^{{\mathit{\boldsymbol{x}}_1}},\mathit{\boldsymbol{h}}_{I,p}^{{\mathit{\boldsymbol{x}}_2}}, \cdots ,\mathit{\boldsymbol{h}}_{I,p}^{{\mathit{\boldsymbol{x}}_n}}} \right]^{\rm{T}}} $ | (10) |

以基于矩形模板的目标表征模型为基础,采用8×8的特征网格对目标进行结构化表示。网格点的每个特征描述符包含8方向的梯度直方图,以及各通道维数为8的RGB颜色直方图,构成32维度向量。在主流目标跟踪方法的目标表征过程中,由于不具备关于目标轮廓方面的知识,对于矩形框内所有位置的特征描述符同等对待。

在本文的模型中,由第1节计算得到的显著性概率图可用于模拟人眼系统注意机制,为目标跟踪算法提供特征选择方面的先验知识,以构造更为精确的目标表征模型。使用特征描述符所在网格点邻域的平均显著性概率对其进行加权,即

| $ {\alpha _\mathit{\boldsymbol{x}}} = \sum\limits_{{\mathit{\boldsymbol{x}}^\prime } \in {\mathit{\Omega }_\mathit{\boldsymbol{x}}}} p \left( {c_{\mathit{\boldsymbol{x'}}}^t = 1|{\mathit{\boldsymbol{Y}}^t}} \right) $ | (11) |

| $ {\mathit{\boldsymbol{h}}_{I,p}} = {\left[ {{\alpha _{{\mathit{\boldsymbol{x}}_1}}}\mathit{\boldsymbol{h}}_{I,p}^{{\mathit{\boldsymbol{x}}_1}},{\alpha _{{\mathit{\boldsymbol{x}}_2}}}\mathit{\boldsymbol{h}}_{I,p}^{{\mathit{\boldsymbol{x}}_2}}, \cdots ,{\alpha _{{\mathit{\boldsymbol{x}}_n}}}\mathit{\boldsymbol{h}}_{I,p}^{{\mathit{\boldsymbol{x}}_n}}} \right]^{\rm{T}}} $ | (12) |

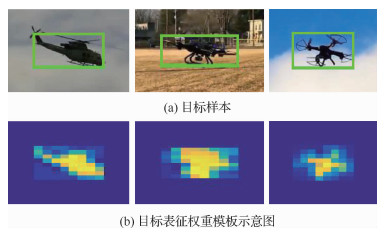

式中:Ωx为像素位置x的邻域像素点集合。图 5给出了一些典型的目标样本以及对应的目标表征权重模板{αxk}。从图中可以看出,权重模板的使用抑制了矩形模板中非显著区域的特征描述符,使得目标表征模型更为精确,能够有效消除背景中疑似物体的干扰。

|

| 图 5 基于显著性的目标表征示意图 Fig. 5 Demonstration of saliency-based target representation |

空中飞行器目标在跟踪过程中由于姿态角度变化,存在的一个典型挑战性因素是如图 1(b)和图 1(c)所示的目标宽高比变化。现有的基于检测的跟踪方法在尺度估计方面,一类典型的做法是采用固定大小的目标模板[10-11],另一类使用固定宽高比的模板,使用一个参数s表示模板的尺度大小,对该参数进行估计[12]或者同时在多个尺度上检测目标[25]。这些做法显然都无法满足对空中飞行器进行鲁棒准确跟踪的需求。

不同于上述方法使用固定宽高比的做法,本文使用sx和sy两个尺度缩放参数分别标记x和y方向的尺度变化,在每一帧进行多方向的多尺度检测。为了避免同时改变2个方向尺度缩放参数带来的计算成本大幅增加,提出一种对2个方向的尺度变化进行分步估计的做法。具体的,首先在不改变目标宽度的情况下,在y方向使用多个尺度缩放因子Sy={0.99, 1, 1.01}进行多尺度并行检测,使用式(9)中目标函数得分最大的N个样本投票决定sy,然后在固定目标高度的情况下,对x方向同样使用多个尺度缩放因子进行多尺度并行检测,使用式(9)选取最优样本作为算法输出结果。由于大多数实际应用中目标尺度变化较为缓慢,同时出于计算成本的考虑,本文在实验与实际应用中均使用3个尺度的缩放因子。

3 实验结果与分析 3.1 实验概述本文实验分为2个部分:第1部分基于课题应用背景,使用提出的算法对空中飞行器进行跟踪,与其他主流方法进行性能比较和分析,并且对本方法进行消融实验分析。第2部分为验证本文算法模型具有一定的通用价值,在最常见的通用物体跟踪数据集OTB-100[9]上进行性能评估,与相关性程度较高的的主流算法进行重点比较。

本文算法在配备了Intel Core i7处理器、8 GB内存的个人计算机上运行,使用C++实现,平均运行帧率为15 fps。对于实验比较的其他主流先进方法,第1部分实验结果使用原作者提供的代码和默认参数,在本课题应用提供的数据集上进行跟踪实验获得,第2部分的实验使用公开的通用物体跟踪数据集OTB-100,直接采用原作者提供的实验结果。

3.2 空中飞行器数据集实验本节实验基于安防等实际应用背景,验证本文算法在常见空中飞行器(飞机、无人机)跟踪任务中相对于其他方法的巨大优势。与主流跟踪数据集中的常见目标相比,空中飞行器跟踪场景具有目标形状、大小、宽高比持续变化、存在复杂背景干扰等突出的难点问题。由于目前尚无结合该应用背景的数据集可用,与项目合作单位采集构建了飞行器跟踪数据集,包含不同天空与地面背景下的10个无人机序列和20个飞机序列,部分序列来自LaSOT数据库[26]。遵循主流目标跟踪数据集的通行做法,视频每一帧中的被跟踪目标使用外接矩形框的方式进行了人工标注,以方便对算法跟踪性能进行评估比较。

在本实验中,选取了16个代表性的方法进行比较,具体可分为4类:①与本文方法同样基于最大间隔分类器的判别式模型算法Struck[24]和MEEM[11];②经典的相关滤波类的算法CSK[27]、KCF[10]、SAMF[28]、Staple[23]、SRDCF[29];③近两年提出的基于手工特征的相关滤波改进算法fDSST[12]、Staple_CA[30]、CSRDCF[31]、ECO_HC[32]以及MCCT_H[33];④近年来兴起的基于深度学习与卷积神经网络特征的CFNet[34]、VITAL[35]、TRACA[36]与ASRCF[37]方法。这些方法尤其是后两类覆盖了目前最先进的主流目标跟踪方法。

遵循主流数据集的评估方法,基于中心位置误差和重叠率指标进行统计,通过精度图和成功率图显示比较各算法的跟踪性能。本实验采用一次通过估计(One Pass Evaluation,OPE)的方式给出跟踪算法的精度图与成功率图,即从视频开头使用标注的基线矩形框进行初始化,对算法在整个视频跟踪过程中的性能指标进行统计,通过考察算法的长期跟踪能力评估其实用价值。

中心位置误差(Center Location Error, CLE)是被广泛使用的一个评价标准,具体指跟踪所得的目标中心位置与基准中心位置之间的欧氏距离,单位为像素,即

| $ {S_{{\rm{CLE}}}} = \sqrt {{{\left( {x_{\rm{p}}^t - x_{\rm{g}}^t} \right)}^2} + {{\left( {y_{\rm{p}}^t - y_{\rm{g}}^t} \right)}^2}} $ | (13) |

式中:(xpt, ypt)为第t帧时跟踪算法计算得到的目标中心位置坐标;(xgt, ygt)为该时刻视频中目标的基准中心位置坐标。可以看出, 中心位置误差仅仅衡量了像素位置的差异,无法反映目标尺度大小上的误差。通常定义SCLE≤20为跟踪成功。

图 6(a)显示了参与测评的算法在数据集上的精度图,横坐标为中心位置误差阈值,纵坐标为精度(Precision),表示中心位置误差小于该阈值的视频帧数比例。使用SCLE为20的精度指标衡量算法在数据集上的综合性能,对其进行排序,显示在算法名称前面。

|

| 图 6 在飞行目标跟踪数据集上的实验结果 Fig. 6 Experimental results of airborne visual tracking dataset |

从图 6(a)中可看出,本文方法在数据集上成功跟踪的帧数比例为40.9%,高于其他使用手工特征的高效算法,其中性能表现最好的ECO_HC和MCCT_H跟踪成功帧数比例分别为38.6%和36.6%。总体上,本文方法与包括VITAL、CFNet、ASRCF在内的基于深度学习的最新跟踪器均取得了较好的跟踪精度。本文方法跟踪精度低于非实时的VITAL跟踪器,略低于CFNet方法,略高于ASRCF方法。

重叠率(Overlap)是另一个常见的算法评价标准, 具体定义为

| $ {S_{{\rm{OVL}}}} = \frac{{A\left( {R_{\rm{g}}^t \cap {R^t}} \right)}}{{A\left( {R_{\rm{g}}^t \cup {R^t}} \right)}} $ | (14) |

式中:Rt为第t帧时算法输出的目标框;Rgt为数据集标注的标准目标框;A(Rgt∩Rt)为2个区域重叠面积;A(Rgt∪Rt)为2个区域并集的面积。重叠率指标在衡量了跟踪算法输出结果与标准值在像素位置上差异的同时,也反映了目标尺度大小估计上的准确程度,在目标尺度估计不准确的情况下算法很难得到高的重叠率指标。

图 6(b)显示了各个算法在数据集上的成功率图,横坐标为不同阈值的重叠率,纵坐标为成功率(Success Rate),表示重叠率大于某个阈值的帧数比例。成功率曲线的曲线下方面积(Area Under Curve,AUC)被用作算法之间排序度量的指标,显示在算法名称前面。在成功率图上排名靠前的为本文方法与基于深度学习的VITAL、ASRCF以及CFNet方法,与精度图显示的结论一致。不同的是,本文方法与VITAL分居前两名,AUC值基本持平,明显高于其他方法,说明本文方法受益于提出的时空显著性估计以及多方向多尺度搜索策略,在目标尺度估计方面具有明显的优势。

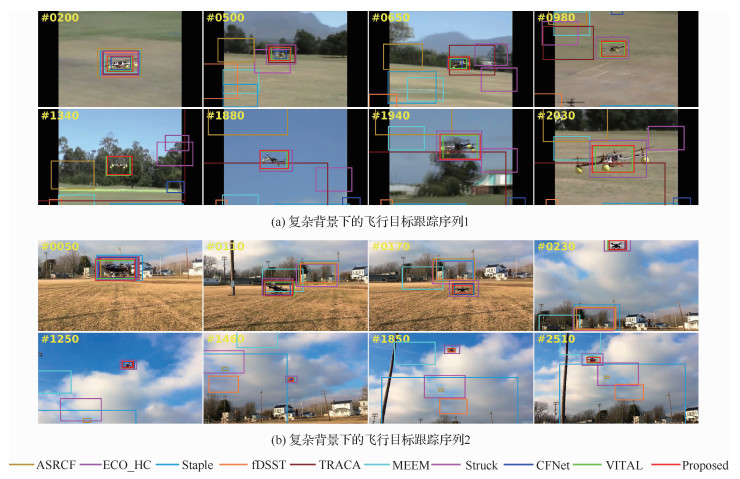

3.3 典型飞行器序列跟踪结果从3.2节使用的空中飞行器跟踪数据集里面,选取了一些典型的序列进行展示分析,以比较跟踪器在常见挑战性因素影响下的鲁棒性。所比较的方法包括本文方法,3.2节实验中性能靠前的基于深度学习的VITAL、CFNet、TRACA和ASRCF方法,以及其他两类方法中的代表性算法Struck、MEEM、fDSST、Staple和ECO_HC方法。

图 7~图 9显示了本文方法和上述9个主流方法在这些典型序列上的跟踪结果,使用不同颜色的矩形框对各跟踪器的输出结果进行标识。为了比较详尽地展示跟踪过程,对每个图像序列按照时间顺序从前到后截取了多幅图像进行分析,图像的帧号在左上角使用黄色的数字显示。

|

| 图 7 较为简单的飞行目标跟踪效果图 Fig. 7 Demonstration of tracking results of simple airborne sequences |

|

| 图 8 复杂背景下的飞行目标跟踪效果图 Fig. 8 Demonstration of tracking results of airborne sequences with background clutter |

|

| 图 9 形状持续变化的飞行目标跟踪效果图 Fig. 9 Demonstration of tracking results of airborne targets undergoing continuous deformation |

1) 较为简单的飞行器序列跟踪效果

图 7(a)显示了一个比较简单的无人机跟踪序列,目标在跟踪过程中姿态、形状、尺度均无明显变化。但是由于受到路面标记和无人机影子的干扰影响,较传统的Struck、fDSST、MEEM算法先后偏离到背景区域,Staple算法存在较大的尺度估计误差导致后期丢失目标。

图 7(b)同样是相对简单的跟踪序列,背景简单干净,飞机在飞行过程中姿态变化不大,仅存在成像距离引起的尺度变化,大多数跟踪器都能够比较准确地定位目标位置。其中,Struck和MEEM方法在第1500帧之后估计的目标尺度过小在后续跟踪过程中出现不同程度的偏移。相比之下,深度学习类的方法与本文方法能够很好地适应飞行目标的尺度变化,得到准确的位置与尺度估计。

图 7(c)和图 7(d)中的序列由于目标存在平面内或平面外的旋转,导致形状、宽高比发生变化,对跟踪器的鲁棒性提出了一定的要求。Staple、MEEM和fDSST方法在这两个序列均中途丢失目标;TRACA方法随着目标形状变化逐渐偏离到背景区域;Struck方法在2个序列中都成功定位到目标物体上,但是尺度估计没有及时调整,出现尺度过大或者过小的情况;CFNet和VITAL在序列图 7(d)中后期丢失目标,在序列图 7(c)上具有很好的跟踪效果;ASRCF和ECO_HC在序列图 7(c)由于尺度估计偏差逐渐偏离目标,导致中途丢失,在序列图 7(d)中后期同样出现明显的尺度估计偏差;本文方法则在两个序列上均具有很好的跟踪精度和鲁棒性。

2) 复杂背景下的飞行器序列跟踪效果

图 8显示了2个典型的复杂背景干扰下的无人机序列,无人机目标在飞行过程中经过草地、树木、建筑物、天空、云层等典型背景,而且存在不同程度的尺度变化,具有很高的跟踪难度。由于序列较长且跟踪过程中背景变化较多,对每个序列均摘取了跟踪过程中的8个画面进行展示分析。

在序列图 8(a)第200帧的时候参与测试的跟踪器都能准确地定位目标位置,到500帧的时候,ASRCF、fDSST、Staple和MEEM方法均跟踪失败,Struck和TRACA也在后续跟踪过程中由于尺度估计过大,在目标框中包含了大量的背景区域,算法建立的目标模型受到背景信息污染,逐渐偏移到背景区域。ECO_HC在650帧左右、1 340帧左右均出现丢失现象,在其他帧存在尺度估计偏大的问题。CFNet在650帧之后完全丢失目标,而VITAL和本文算法则在后续背景切换和尺度变化的干扰下,完成整个序列2 000多帧图像的稳定跟踪。

序列图 8(b)显示了类似的跟踪效果。在第50帧的时候所有的跟踪器均能准确定位目标,而在后续的目标快速移动与尺度变小过程中,尺度估计不准确的ASRCF、Staple、fDSST、Struck和MEEM跟踪器先后偏移到背景区域,逐渐丢失目标。本文方法与ECO_HC、VITAL、CFNet、TRACA均对总共2 000多帧图像完成了飞行器目标的长时间稳定跟踪,在后期本文算法的尺度估计明显比其他方法更为准确。

3) 形状持续变化的飞行器序列跟踪效果

不同于传统视频监控场景中的行人/车辆等目标成像视角固定,形状与宽高比没有显著变化,尺度变化缓慢,飞行器目标在跟踪过程中存在视角变化、距离变化、目标翻转运动等引起的目标形状、尺度、宽高比持续变化,对于跟踪算法在定位与尺度估计上的精度都具有较高的要求。图 9展示了此类飞行器跟踪序列中的2个例子,每个序列均展示了跟踪过程中的8个画面。从图中可以看到,对于这两个高难度的跟踪序列,本文方法总体上能够很好地适应目标形状与宽高比变化,虽然在序列图 9(b)第800帧存在目标尺度估计不够准确的问题,但是仍然取得了比其他所有跟踪器更加准确的跟踪结果,而且受益于时空显著性模型提供的目标定位信息,在目标的后续变化中仍然能够及时调整,保持对目标的准确定位,具有非常突出的鲁棒性。

总体上,本文方法和VITAL在目标定位和尺度估计上均具有较高的精度,其他基于深度学习的方法目标定位方面表现较优,但是在目标的尺度估计方面精度不足。相比之下,VITAL方法运行帧率低于1 fps,远小于本文方法,暂时不具备在实际需求场景中应用的潜力。本文方法与CFNet、ASRCF、TRACA等深度学习方法相比,不仅具有尺度估计更加准确的优势,而且由于没有使用卷积神经网络特征,不依赖于使用高性能GPU设备进行特征计算来达到实时跟踪效果,可以用于一些不配备高性能GPU的场景,具有更广泛的应用范围。

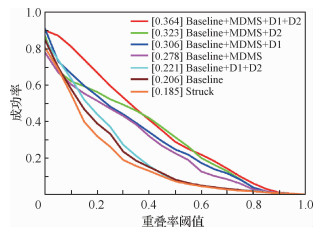

3.4 消融实验为论证方法主要思想对最终性能的影响,针对使用到的不同观测以及多方向多尺度搜索策略,在飞行目标跟踪数据集上对本文方法进行消融实验分析,在图 10中显示了实验结果的成功率。本文方法各模块标识如下:① Baseline表示本文提出的基准方法,使用最大间隔分类器配合2.2节提到的特征,不使用多方向多尺度搜索策略,不使用显著图进行特征选择;② MDMS(Multi-Direction Multi-Scale)表示2.3节提出的多方向多尺度搜索策略;③ D1表示应用显著图进行特征选择,使用1.2节提出的观测量;④ D2表示应用显著图进行特征选择,使用1.3节提出的观测量。本文最终采纳的方案即Baseline+MDMS+D1+D2。此外,Struck是使用最大间隔分类器的经典基准方法[24],使用Haar特征进行目标表征,用于和Baseline对比。

|

| 图 10 在飞行目标跟踪数据集上的消融分析 Fig. 10 Ablation analysis on airborne tracking dataset |

图 10中的实验结果显示了若干重要的结论:①在单独消去D1、D2和MDMS模块的情况下,本文方法性能出现不同程度的下降,成功率图的AUC分数分别减小4.1%、5.8%和14.3%;②在Baseline上直接增加显著性模型,成功率图的AUC从20.6%提升到22.1%,变化不明显,而在Baseline+MDMS上,显著性的加入使得AUC从27.8%提升到36.4%,表明MDMS对于显著性的准确估计具有积极的影响,在本文方法中发挥十分重要的作用;③在Baseline+MDMS上,D1和D2的组合使用相比于单独使用带来了更为明显的性能提升,说明两者提供的信息具有一定的互补性。上述结果表明,本文方法各模块之间具有密切的联系,且对方法的性能提升均具有实质性的贡献。

3.5 通用物体跟踪性能为了验证本文的建模方法具有一定的通用价值,在目标跟踪领域最常用的OTB-100测试数据集[9]上与主流的方法进行比较分析。参与比较的相关滤波类的代表性方法有DSST[12]、KCF[10]、Staple[23]、SRDCF[29]、ECO_HC[32]以及MCCT_H[33],深度学习类的代表性方法有CFNet[34]、ACFN[38]、TRACA[36]与ASRCF[37]方法。其中,ACFN具有和本文方法类似的出发点,对目标邻域的显著性进行了建模和估计。其他参与比较的Struck[24]、CNN-SVM[19]、LMCF[39]、MEEM[11]、DLSSVM/Scale-DLSSVM[25]方法与本文方法一样,采用了最大间隔分类器作为基准分类模型,是本节实验比较的重点。

与3.2节的实验类似,使用一次通过测试,即从视频开头使用真值进行初始化,对跟踪过程中的每一帧使用式(13)和式(14)分别计算中心位置误差和重叠率指标,再分别进行统计比较。图 11(a)显示了参与测评的算法在OTB-100上的精度图,横坐标为中心位置误差阈值,纵坐标为相应的距离精度,算法名称前面的中括号里显示了中心位置误差为20的距离精度,用来对算法进行排序。图 11(b)显示了各个算法在数据集上的成功率图,横坐标为不同阈值的重叠率,纵坐标为成功率,成功率图曲线的AUC被用作算法之间排序度量的指标。

|

| 图 11 OTB-100测试数据集上的实验结果 Fig. 11 Experimental results of OTB-100 test dataset |

从图 11中可以看到,虽然本文模型针对形状宽高比变化的空中飞行器提出,但是在通用物体跟踪任务上也有不错的性能表现,在精度图与成功率图上性能指标均优于包括TRACA、CFNet、ACFN、LMCF等在内的主流跟踪方法中的代表性方法。本文方法在成功率图上的AUC为60.5%,相比于基准方法Struck的46.2%提升了14.3%,典型精度则从63.9%提升到了82.0%。

表 1给出了已知的使用最大间隔分类器方法的主流跟踪方法,第2列给出了算法的典型精度(中心位置误差小于20像素的帧数百分比),第3列给出了典型成功率(重叠率大于0.5的帧数百分比),并列出了每个方法的特点。

| 方法 | 精度/ % |

成功率/ % |

特点 |

| Struck | 63.86 | 51.91 | |

| MEEM | 78.12 | 62.16 | 多跟踪器融合 |

| DLSSVM | 76.17 | 62.36 | |

| Scale-DLSSVM | 80.17 | 64.89 | 多尺度估计的DLSSVM |

| CNN-SVM | 81.36 | 65.14 | 通过CNN特征构造显著图 |

| LMCF | 78.86 | 71.89 | 提出多峰检测策略 |

| Proposed | 82.03 | 73.84 | 建模时空显著性 |

其中,CNN-SVM方法通过CNN特征反向投影构造显著图,用于指导目标表征模型的构建,取得了同类方法里面的次优精度,但是成功率仅为65.14%,与本文方法的73.84%有较大的差距。提出多峰检测策略的LMCF方法取得了同类方法里的次优成功率,但是成功率与精度均明显低于本方法。Scale-DLSSVM在DLSSVM基础上加入多尺度估计,以牺牲运行效率为代价提升了算法对目标尺度变化的适应能力,精度与成功率均有明显提升,但是与本文方法相比仍然有一定差距。以上结果说明,本文方法在跟踪精度与鲁棒性上均优于其他同类方法,估计的显著图以及提出的目标表征模型十分有效地提升了方法对目标尺度与形状变化的鲁棒性。

4 结论1) 本文提出一种新颖的时空显著性估计模型。通过对跟踪场景中的多帧图像观测数据以及背景先验信息进行利用,估计的显著图对背景噪声干扰具有很强的鲁棒性,能够指导空中飞行器跟踪算法构建精确目标表征模型,有效提升方法模型的鲁棒性。

2) 提出的多方向多尺度目标搜索策略使得跟踪算法在保证实时性的同时,更好地利用视觉表征信息,实现对目标宽高比变化的自适应调整。

3) 提出的方法能够克服空中飞行器跟踪过程中背景复杂、目标形状、宽高比变化等因素的干扰,跟踪精度与鲁棒性优于大多数最先进的主流方法,并且在精度/鲁棒性/平台要求/运行速度上具有显著的综合优势,具有很高的实用价值。

4) 方法在其他类型物体的跟踪任务上跟踪精度与鲁棒性均优于其他同类方法,提出的思想方法与建模技术具有一定的普适性。

| [1] |

刘芳, 王洪娟, 黄光伟, 等. 基于自适应深度网络的无人机目标跟踪算法[J]. 航空学报, 2019, 40(3): 322332. LIU F, WANG H J, HUANG W G, et al. UAV target tracking algorithm based on adaptive depth network[J]. Acta Aeronautica et Astronautica Sinica, 2019, 40(3): 179-188. (in Chinese) |

| Cited By in Cnki (3) | Click to display the text | |

| [2] |

邵干, 张曙光, 唐鹏. 小型无人机气动参数辨识的新型HGAPSO算法[J]. 航空学报, 2017, 38(4): 49-59. SHAO G, ZHANG S G, TANG P. HGAPSO:A new aerodynamic parameters identification algorithm for small unmanned aerial vehicles[J]. Acta Aeronautica et Astronautica Sinica, 2017, 38(4): 49-59. (in Chinese) |

| Cited By in Cnki (7) | Click to display the text | |

| [3] | GANTI S R, KIM Y. Implementation of detection and tracking mechanism for small uas[C]//2016 International Conference on Unmanned Aircraft Systems. Piscataway, NJ: IEEE Press, 2016: 1254-1260. |

| Click to display the text | |

| [4] | STURDIVANT R L, CHONG E K. Systems engineering baseline concept of a multispectral drone detection solution for airports[J]. IEEE Access, 2017, 5: 7123-7138. |

| Click to display the text | |

| [5] |

赵洲, 黄攀峰, 陈路. 一种融合卡尔曼滤波的改进时空上下文跟踪算法[J]. 航空学报, 2017, 38(2): 269-279. ZHAO Z, HUANG P F, CHEN L. A tracking algorithm of improved spatio-temporal context with Kalman filter[J]. Acta Aeronautica et Astronautica Sinica, 2017, 38(2): 269-279. (in Chinese) |

| Cited By in Cnki (18) | Click to display the text | |

| [6] |

王晓.视频中无人机的实时检测与跟踪算法研究[D].哈尔滨: 哈尔滨工程大学, 2019. WANG X. Research on real-time detection and tracking algorithm of UAV in video[D]. Harbin: Harbin Engineering University, 2019 (in Chinese). |

| [7] |

郭晓冉, 崔少辉, 毛向东, 等. 背景干扰下的捷联图像导引系统目标跟踪方法[J]. 兵器装备工程学报, 2017, 38(3): 1-5. GUO X R, CUI S H, MAO X D, et al. Strapdown image homing system target tracking approach under the interference of background[J]. Journal of Ordnance Equipment Engineering, 2017, 38(3): 1-5. (in Chinese) |

| Cited By in Cnki | Click to display the text | |

| [8] |

吕梅柏, 赵小锋, 刘广哲. 空中大机动目标跟踪算法研究[J]. 现代防御技术, 2018, 46(2): 45-50. LV M B, ZHAO X F, LIU G Z. Aerial high maneuvering target tracking algorithm[J]. Modern Defence Technology, 2018, 46(2): 45-50. (in Chinese) |

| Cited By in Cnki | Click to display the text | |

| [9] | WU Y, LIM J, YANG M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848. |

| Click to display the text | |

| [10] | HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596. |

| Click to display the text | |

| [11] | ZHANG J, MA S, SCLAROFF S. MEEM: Robust tracking via multiple experts using entropy minimization[C]//2014 European Conference on Computer Vision, 2014: 188-203. |

| Click to display the text | |

| [12] | DANELLJAN M, HÄGER G, KHAN F S, et al. Discriminative scale space tracking[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(8): 1561-1575. |

| Click to display the text | |

| [13] |

孙丰东.图像显著性检测若干关键问题研究[D].长春: 吉林大学, 2019. SUN F D. Research on several key issues of image saliency detection[D]. Changchun: Jilin University, 2019 (in Chinese). |

| [14] | STRAND R, CIESIELSKI K C, MALMBERG F, et al. The minimum barrier distance[J]. Computer Vision and Image Understanding, 2013, 117(4): 429-437. |

| Click to display the text | |

| [15] | ZHANG J, SCLAROFF S, LIN Z, et al. Minimum barrier salient object detection at 80 fps[C]//2015 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE Press, 2015: 1404-1412. |

| Click to display the text | |

| [16] | LIU C, YUEN P C, QIU G. Object motion detection using information theoretic spatio-temporal saliency[J]. Pattern Recognition, 2009, 42(11): 2897-2906. |

| Click to display the text | |

| [17] | YANG M, YUAN J, WU Y. Spatial selection for attentional visual tracking[C]//2007 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2007: 1-8. |

| Click to display the text | |

| [18] | FAN J, WU Y, DAI S. Discriminative spatial attention for robust tracking[C]//2010 European Conference on Computer Vision, 2010: 480-493. |

| Click to display the text | |

| [19] | HONG S, YOU T, KWAK S, et al. Online tracking by learning discriminative saliency map with convolutional neural network[C]//2015 International Conference on Machine Learning. Lille: The International Machine Learning Society, 2015: 597-606. |

| Click to display the text | |

| [20] | CHOI J, JIN CHANG H, JEONG J, et al. Visual tracking using attention-modulated disintegration and integration[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2016: 4321-4330. |

| Click to display the text | |

| [21] | WEI Y, WEN F, ZHU W, et al. Geodesic saliency using background priors[C]//2012 European Conference on Computer Vision, 2012: 29-42. |

| Click to display the text | |

| [22] | POSSEGGER H, MAUTHNER T, BISCHOF H. In defense of color-based model-free tracking[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2015: 2113-2120. |

| Click to display the text | |

| [23] | BERTINETTO L, VALMADRE J, GOLODETZ S, et al. Staple: Complementary learners for real-time tracking[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2016: 1401-1409. |

| Click to display the text | |

| [24] | HARE S, GOLODETZ S, SAFFARI A, et al. Struck:Structured output tracking with kernels[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(10): 2096-2109. |

| Click to display the text | |

| [25] | NING J, YANG J, JIANG S, et al. Object tracking via dual linear structured svm and explicit feature map[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2016: 4266-4274. |

| Click to display the text | |

| [26] | FAN H, LIN L, YANG F, et al. Lasot: A high-quality benchmark for large-scale single object tracking[C]//2019 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2019: 5374-5383. |

| [27] | HENRIQUES J F, CASEIRO R, MARTINS P, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]//2012 European Conference on Computer Vision, 2012: 702-715. |

| Click to display the text | |

| [28] | LI Y, ZHU J. A scale adaptive kernel correlation filter tracker with feature integration[C]//2014 European Conference on Computer Vision Workshops, 2014: 254-265. |

| Click to display the text | |

| [29] | DANELLJAN M, HAGER G, SHAHBAZ KHAN F, et al. Learning spatially regularized correlation filters for visual tracking[C]//2015 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE Press, 2015: 4310-4318. |

| [30] | MUELLER M, SMITH N, GHANEM B. Context-aware correlation filter tracking[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2017: 1396-1404. |

| Click to display the text | |

| [31] | LUKEZIC A, VOJIR T, ?EHOVIN ZAJC L, et al. Discriminative correlation filter with channel and spatial reliability[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2017: 6309-6318. |

| Click to display the text | |

| [32] | DANELLJAN M, BHAT G, SHAHBAZ KHAN F, et al. ECO: Efficient convolution operators for tracking[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2017: 6638-6646. |

| Click to display the text | |

| [33] | WANG N, ZHOU W, TIAN Q, et al. Multi-cue correlation filters for robust visual tracking[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2018: 4844-4853. |

| [34] | VALMADRE J, BERTINETTO L, HENRIQUES J, et al. End-to-end representation learning for correlation filter based tracking[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2017: 2805-2813. |

| [35] | SONG Y, MA C, WU X, et al. Vital: Visual tracking via adversarial learning[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2018: 8990-8999. |

| Click to display the text | |

| [36] | CHOI J, JIN C H, FISCHER T, et al. Context-aware deep feature compression for high-speed visual tracking[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2018: 479-488. |

| Click to display the text | |

| [37] | DAI K, WANG D, LU H, et al. Visual tracking via adaptive spatially-regularized correlation filters[C]//2019 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2019: 4670-4679. |

| [38] | CHOI J, JIN C H, YUN S, et al. Attentional correlation filter network for adaptive visual tracking[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2017: 4807-4816. |

| Click to display the text | |

| [39] | WANG M, LIU Y, HUANG Z. Large margin object tracking with circulant feature maps[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2017: 4021-4029. |

| Click to display the text |